根據 Digiconomist 網站創始人於 10 月 10 日在《Joule》期刊上發表論文,認為以 ChatGPT、Bing Chat 為代表的生成式 AI,會產生龐大的能源足跡,未來可能會超過一些國家的電力需求。

該論文作者,來自阿姆斯特丹自由大學的亞歷克斯・德弗里斯表示:「考慮到對人工智慧服務不斷增長的需求,未來幾年與人工智慧相關的能源消耗很可能會顯著增加」,該研究強調到 2027 年,生成式人工智慧所消耗的能源可為一個小國家提供一年的電力,相當於約 85-134 太瓦時 (TWh) 的電力。

研究指出生成式 AI 所消耗的能源,到了2027 年用電量將超過某些國家一年耗電

總部位於紐約的人工智慧開發公司 Hugging Face 報告稱,其多語言文字生成人工智慧工具在訓練期間消耗了約 433 MWH,足以為 40 個普通美國家庭提供一年的電力。

生成式AI的運算需求

訓練大型語言模型(LLMs),比如OpenAI的ChatGPT,以及Google的同類產品Bard,意味著在大量資料中解析和運算聯繫,這就是這些模型往往是由擁有大量資源的公司開發的原因。這些模型需要大量的運算能力,目前只有大型科技公司才能訓練這些模型。

雖然OpenAI和Google都沒有說過他們各自產品的運算成本是多少,但研究人員的協力廠商分析估計,ChatGPT部分基於GPT-3的訓練消耗了1287兆瓦時,並導致了超過550噸的二氧化碳排放量。

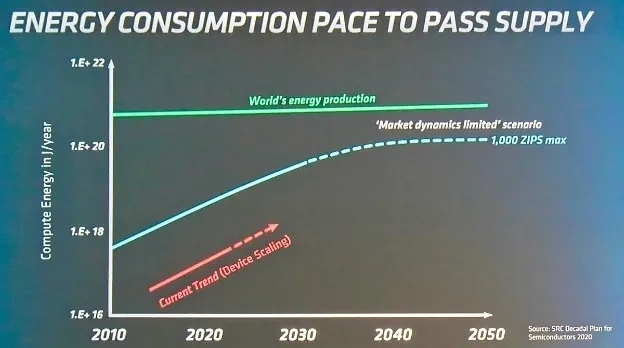

而在最近的設計自動化大會(Design Automation Conference)上,AMD 首席技術官 Mark Papermaster 放出了一張幻燈片,上面展示了機器學習系統的能耗(圖 1)與全球發電情況的對比。

加拿大資料中心公司QScale聯合創始人馬丁·布沙爾(Martin Bouchard)認為,如果在搜尋過程中加入生成式人工智慧,需要「每次搜尋至少增加4到5倍的運算量」。他指出,ChatGPT先前對2021年底之後的事情是不理解的,這在一定程度上減少了運算需求。但為了滿足搜尋引擎使用者日益增長的需求,這將不得不改變。

環境足跡和能源成本

為了減少「將人工智慧整合到搜尋中」的環境足跡和能源成本,可以將資料中心轉移到更清潔的能源上,以及重新設計神經網路以提高效率,減少所謂的「推理時間」(即演算法在新資料上工作所需的運算能力)。

谷歌發言人珍·派克(Jane Park)告訴《連線》雜誌,Google最初發表的Bard版本是由一個羽量級大型語言模型提供支援的。派克說:「我們還發表了一項研究,詳細介紹了最先進的語言模型的能源成本,包括早期和更大版本的LaMDA。我們的研究結果表明,將高效的模型、處理器和資料中心與清潔能源相結合,可以將[機器學習]系統的碳足跡減少1000倍。」

人工智慧的能源足跡並不會隨著訓練而結束。德弗里斯的分析表明,當該工具投入工作(根據提示生成資料)時,每次該工具生成文字或圖像後,它也會使用大量的計算能力,從而消耗大量的能源。例如,ChatGPT 每天的運行費用可能為 564 MWh。

Google已經將生成式人工智慧納入公司的電子郵件服務中,並正在測試利用人工智慧為其搜尋引擎提供動力。目前該公司每天處理多達 90 億次搜尋。根據資料,德弗里斯估計,如果Google每次搜尋都使用人工智慧,每年大約需要 29.2 TWh 的電力,相當於愛爾蘭一年的用電量。

|

「臺灣能源期刊」第十卷第三期已出版,免費下載與閱讀。 |

|---|---|

|

ETC「智慧電網及智慧家庭之資安與互通性檢測技術研討會」訊息 |